Les résultats d’une étude “statistiquement significatifs” n’impliquent pas forcément un bénéfice ou une avancée pour les malades. Un résultat doit avant tout être cliniquement significatif. Faisons le point sur l’importance de cette différence.

Sommaire

Le Graal du “statistiquement significatif”

Les études scientifiques, que l’on parle de sciences sociales ou médicales, reposent sur l’utilisation de calculs statistiques (pas toujours néanmoins) à un moment ou un autre.

La fameuse “p-value” et son seuil fatidique de 5% sont bien connu et représentent la base pour différencier un véritable effet du simple hasard. C’est le Graal de tout chercheur, l’objectif inavoué de chaque équipe scientifique : trouver un effet statistiquement significatif.

Pourquoi ? Car les journaux scientifiques s’empressent plus facilement d’accepter et de publier des études qui montrent des différences statistiquement significatives plutôt que… rien du tout. C’est un problème en science, car même des résultats négatifs sont importants, et les éditeurs pressurisent quelque part les chercheurs pour ne publier que des choses qui fonctionnent.

Pourtant, publier des données sur l’inefficacité de certains médicaments est important pour prendre des décisions de santé publique. À force de ne publier que les études qui “marchent” et pas les autres, vous vous rendez compte qu’on fausse l’impression globale.

Bref, je ferme cette petite parenthèse et je reviens à ce terme, statistiquement significatif, que vous avez déjà entendu dans la presse, de la bouche d’un conférencier sur le climat ou dans une banale discussion entre amis.

Alors je vous rassure, on ne va parler de modèles mathématiques ou d’hypothèses statistiques complexes – on laisse cela aux statisticiens – mais plutôt d’une différence fondamentale que l’on fait peu en science entre le statistiquement et le cliniquement significatif.

Car un résultat peut être statistiquement significatif (hourra !), mais cliniquement insignifiant. Autrement dit, la différence fera plaisir aux éditeurs et aux équipes scientifiques, mais n’apportera rien aux patients et à la pratique clinique.

L’importance du cliniquement significatif

C’est monstrueusement important. Faire la différence entre les deux termes implique de vouloir comprendre les résultats à la lumière de la pratique clinique et de la réalité du terrain. Car même statistiquement positif, des résultats peuvent ne rien vouloir dire (ou si peu).

Le cas des traitements contre le cancer

Les études sur les traitements du cancer sont des exemples tristement éclairants de ce gouffre entre le cliniquement et le statistiquement significatif. En 2007, une équipe canadienne prouve l’efficacité d’un traitement contre le cancer avancé du pancréas sur la survie des malades.

Les auteurs concluent avec assurance que “cet essai de phase III randomisé est le premier à démontrer une amélioration statistiquement significative de la survie dans le cancer du pancréas avancé en ajoutant un agent à la gemcitabine.”

Ils ont manifestement obtenu ce qu’ils voulaient, une différence statistiquement significative. Pourtant, le groupe qui a bénéficié de ce temps supplémentaire de vie n’a profité en réalité que de 10 jours de plus.

10 jours en plus en rajoutant un énième traitement toxique, sans parler du coût de la thérapie, font des résultats de cette étude une réalité cliniquement insignifiante, non significative. Peut-être même non éthique.

C’est la réalité pour la vaste majorité des nouvelles thérapies contre le cancer, avec des groupes comparés suffisamment grands pour observer des différences (statistiquement significative…), mais qui n’apporteront aux malades qu’un mois ou deux de plus à vivre.

J’en parle en détail dans mon livre explosif, “Santé, mensonges et (toujours) propagande”.

Alzheimer : des médicaments (très) discutables

Nous avions eu le même problème il y a peu de temps avec les médicaments contre la maladie d’Alzheimer. Des traitements qui apportaient des réponses positives pour les patients, avec des différences “statistiquement significatives”, mais ne se traduisaient en rien en termes de pertinence clinique.

Pour l’un de ces médicaments, le rivastigmine, les patients sous traitement avaient bien une amélioration significative des échelles qui mesurent les fonctions de cognitive… mais de seulement 2 points sur 70. La pertinence clinique est quasi-inexistante, d’où le déremboursement de l’ensemble des médicaments.

Comment évaluer la qualité des sources ? Aujourd’hui nous devons littéralement nous débrouiller dans une jungle d’information où certaines “lianes” sont plus résistantes et sûres que d’autres. Mais comment savoir ? Découvrez dans cet article les règles principales pour identifier la qualité d’une source et, surtout, les pièges des analyses officielles. Bien souvent, les analyses officielles se basent sur la notoriété ou bien sur l’argument d’autorité pour faire valoir l’intérêt d’une source, alors qu’il faudrait revenir (systématiquement) aux études scientifiques. Un article à mettre entre toutes les mains.

Comment évaluer la qualité des sources ? Aujourd’hui nous devons littéralement nous débrouiller dans une jungle d’information où certaines “lianes” sont plus résistantes et sûres que d’autres. Mais comment savoir ? Découvrez dans cet article les règles principales pour identifier la qualité d’une source et, surtout, les pièges des analyses officielles. Bien souvent, les analyses officielles se basent sur la notoriété ou bien sur l’argument d’autorité pour faire valoir l’intérêt d’une source, alors qu’il faudrait revenir (systématiquement) aux études scientifiques. Un article à mettre entre toutes les mains.

L’exemple avec l’homéopathie

On retrouve aussi cette tendance à ne miser que sur la différence statistique dans les études sur l’homéopathie. Sujet controversé par excellence, il n’y a pas de preuve rigoureusement solide que l’homéopathie diffère d’un effet placebo (même du côté vétérinaire).

Toutefois, toutes les études sont bien sûr discutables et discutées, et certaines équipes de recherches parviennent à montrer des effets “statistiquement significatifs” d’un traitement homéopathique sans trop s’attarder sur la pertinence clinique de la découverte.

Prenons l’exemple – certainement pas le plus glamour – de la diarrhée chez le nourrisson.

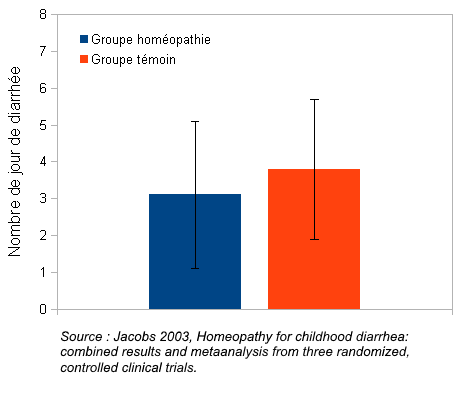

Plusieurs essais cliniques contrôlés et randomisés sur la durée des diarrhées chez des nourrissons ont été analysés dans une étude globale, une méta-analyse (lire ici les problèmes avec les méta-analyses). Les auteurs ont compilé les données, et bingo, la p-value est inférieur à 5%, le traitement homéopathique est différent du placebo !

Les auteurs concluent que “l’homéopathie doit être envisagée comme complément de la réhydratation orale pour cette maladie.”

Mais quelle est la pertinence clinique de cette découverte ? Sans traitement homéopathie, il n’y avait plus de diarrhée au-delà de 7 jours. Classique. Mais le traitement homéopathique a permis de réduire de 0,66 jour, soit 16h la durée des diarrhées.

On peut se poser la question de pertinence clinique de réduire de 16h une diarrhée sur une période de 150 voire 160 heures (et cela sans discuter des autres biais méthodologiques). D’où l’intérêt de ne pas s’arrêter aux seules analyses statistiques.

L’homéopathie est-elle réellement inutile et inefficace ?

L’homéopathie déchaîne les passions. Elle vient récemment d’essuyer une nouvelle attaque en règle de la médecine conventionnelle, qui demande le déremboursement des pilules sucrées, dont la prescription pourrait être dangereuse.

Pourtant, si l’homéopathie ne bénéficie pas d’étude sérieuse franchement favorable, certains éléments méritants considération (étude EPI 3). On revient également sur l’effet de l’homéopathie chez nos amis les bêtes. Aussi, un exemple éclairant sur le cancer du sein.

Allez au-delà du “statistiquement significatif”

Ne pas s’attarder uniquement sur les résultats statistiques d’une étude est réellement important pour commencer une analyse plus fine et rigoureuse de l’étude en question.

Élargir son analyse à la pertinence clinique des résultats n’est pas non plus mince affaire et ne se règle pas aussi facilement que peut le sous-entendre cet article. Son analyse passe – malheureusement – par d’autres paramètres tout aussi importants que nous rappelle Phil Page, de l’Université d’état de Lousiane.

Il faudra également :

- vérifier la qualité du design ou du protocole de l’étude

- rechercher tous les biais possibles qui pourrait altérer l’interprétation des résultats

- vérifier la taille de l’échantillonnage (est-il correct et suffisant ?)

- vérifier l’effet de taille ou la magnitude de l’effet mesure (effect size)

- analysez les intervalles de confiance des résultats, etc.

Vous avez avec cet article une nouvelle vision de la lecture des articles scientifiques et des résultats parfois grandiloquents et “statistiquement significatifs”.

Aujourd’hui toutefois, de plus en plus de chercheurs essayent d’inclure des analyses de pertinence clinique à leur étude, et des codes de conduite permettent de s’en rapprocher (CONSORT notamment), apportant quelques garanties.

Mais ce n’est pas non plus la majorité qui se conduit ainsi. Plus que jamais, la compréhension des résultats scientifiques nécessite que vous ayez un esprit critique acéré et une lecture minutieuse des informations pour vous forger un avis éclairé.

Comprendre une étude scientifique.

Si vous voyez souvent passer des articles de la presse disant “une étude dit que…” sans vraiment savoir ce que sont ces études. Voici un article pour découvrir les entrailles, pas si mystérieuses que ça, des fameuses études scientifiques.